Вы здесь

Главная > Важно знать > Нужно продвинуть сайт в Интернете? Узнайте, как работают поисковые системы!Нужно продвинуть сайт в Интернете? Узнайте, как работают поисковые системы!

Рады снова приветствовать вас, уважаемые друзья, на нашем сайте. Мы надеемся, что вы несколько разобрались в нюансах и деталях создания коммерческого сайта, а также в возможных способах его продвижения.

Так что вы уже имеете некоторые знания и понятия и решили, какие цели стоят перед вашим ресурсом, и какие задачи в первую очередь вы должны решить. Также уже вы нашли потенциального покупателя, определили ключевые признаки эффективной работы вашего ресурса и найдены каналы, по которым вы будете его продвигать.

В случае если одним из инструментов продвижения ресурса вы выбрали SEO, тогда вы должны интересоваться более глубоким изучением этого метода. Так что давайте вместе попробуем на себе испытать, а что это такое быть SEO оптимизатором, который занимается продвижением ресурсов, в том числе и вашего, в Интернете.

Думаем, что вам будет интересно по полочкам разобрать методы, используемые в SEO продвижении, какие из них наиболее действенны. Да и некоторые нюансы работы поисковиков также следует знать и понимать.

Оптимизатор сайта или как работается SEOшникам?

Стоит сразу сказать, что мир SEO – это особая философия, в которой разобраться смогут не все. Это особенная составляющая характера человека, так как специалисту придется столкнуться со многими задачами, которые придется решать постоянно:

1. Действовать приходится в непрерывной (перманентной) трансформации алгоритмов работы поисковиков. Базовые принципы работы, которые вы уже знаете, остаются такими же, но некоторые важные нюансы изменяются. А они имеют существенное значение для компании, которая занимается продвижением ресурсов.

Если говорить о практике, то фактически все закономерности, которые раньше были ключами оптимизатора для продвижения сайта, могут все одновременно стать неэффективными, и никто вам не даст гарантию, что используемые методы на данном этапе, завтра также будут работать. Тот, кто предпочитает стабильную и понятную работу, не сможет успешно оптимизировать сайт, а, значит, и не приживется в компании, занимающейся продвижением ресурсов в Интернете.

2. Если вы выбираете работу специалиста по SEO продвижению, вы можете в прямом смысле «жить» новым проектом. То есть не спать по ночам, пока не ухватитесь за интересную мысль, постоянно раздумывать, что и как лучше сделать, но в итоге проект, предоставленный вам заказчиком, продвигаться не будет, а то дела у него даже еще и ухудшаться.

И в то же время, другой сеошник не будет так «болеть» своим проектом, практически им не занимается, а, продвигаемый им сайт, будет показывать ТОП в выдаче поисковыми сайтами. Так что мотивация у оптимизаторов достаточно низкая, что бы делать постоянные трудовые подвиги. Просто некоторые вещи им не подвластны, а успех, очень часто, зависит не от трудоспособности, а от везения.

3. Стоит учитывать и то, что на данный момент на рынке опытных и грамотных SEO специалистов меньше, чем требуется. Так что нельзя говорить о высокой квалификации о среднестатистическом сеошнике, она низкая. Ведь мы не имеем ни институтов, ни академий, которые бы выпускали действительно грамотных специалистов нужного количества и качества. Большинство оптимизаторов проходят курсы, изучают книги, которые сейчас уже утратили свою актуальность, читают статьи блогеров.

4. Но и повысить свою квалификацию и знания SEO специалистам мешает и то, что изучаемый ими предмет не желает поддаваться изучению и раскрывать свои секреты.

Системы поиска никак не заинтересованы, чтобы оптимизаторы могли с ними открыто беседовать. Это связано с тем, что они разведены в разные стороны от баррикады. Так что знания к сеошнику приходят в процессе постоянного наблюдения за поисковыми машинами и ставят свои опыты. Это не самый действенный и простой метод изучения. Да и друг с другом специалисты SEO оптимизации не спешат делиться опытом и знаниями.

5. Также стоит учитывать, что не каждый ресурс, предлагаемый заказчиком, поддается продвижению посредством SEO в сегодняшних условиях. Ведь их разработка могла быть давно или тогда не учли возможности последующей оптимизации под поисковики.

6. Часто происходит такая ситуация, что владелец ресурса и сам толком не может понять, а чего же он хочет? И те задачи, которые стоят перед оптимизатором, совершенно не отвечают настоящим целям, которые заказчик желает получить по итогам работы специалиста. Тогда и возникают трения, но ведь клиент прав в любой ситуации, не так ли? А дальше…

Разнообразность поисковиков или продвижение по всем фронтам

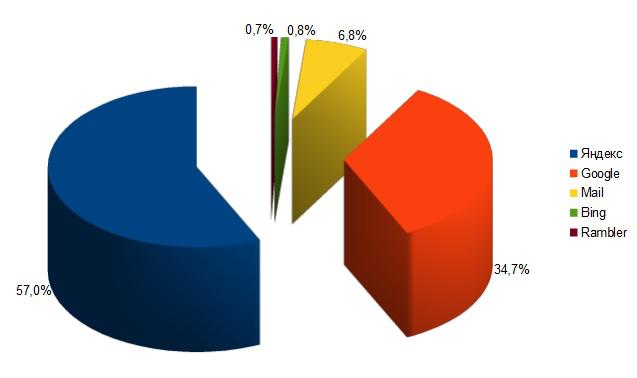

Как будто оптимизатору мало вышеперечисленных сложностей, теперь еще нужно подстроиться, как минимум, под две самые популярные поисковые системы – Yandex и Google. Но, зачастую, приходится брать во внимание и третью – Mail.ru. Хотя процентное соотношение по посещаемости этих сайтов и разное, но если выпустить хоть один из этих поисковиков, можно потерять неплохую долю посетителей, которые могут стать не просто покупателями, а постоянными клиентами вашего ресурса.

ИЛИ

Что бы там ни было, а отказаться от продвижения в Гугл нельзя, оптимизировать коммерческие ресурсы всегда нужно обязательно под эти два поисковика. И хотя в России Yandex занимает первое место, опережая Google практически в 2 раза, то стоит посмотреть ситуацию по всей планете, которая кардинально меняется. Google в двадцать раз опережает Yandex.

Так, что беря во внимание мировой уровень, эти две поисковые машины даже невозможно сопоставлять. Ресурсы, как людские, так и финансовые, и аппаратные на порядок выше.

Это все как раз и оказывает влияние на алгоритмы работы Google, и на его быстроту в общем. И если мы снова посмотрим на рунет, тогда увидим, что и аудитория в этих двух поисковых машинах различная. Стоит подумать о том, что, возможно, аудитория, которая потенциально может быть вашей клиентурой, использует в поиске только систему Гугл.

Говоря откровенно, стоит отметить, что Яндексом пользуются чайники. Нельзя сказать, что это плохо, так как они также могут стать прекрасными покупателями, но если ваша продукция или услуги рассчитываются на продвинутых пользователей, тогда есть все шансы, что Гугл будет вашим основным поставщиком трафика.

Вы, скорей всего, не сможете найти действительно полезные и масштабные исследования в паблике по этому поводу, но думается нам, что, развивая и продвигая собственный ресурс, вам очень быстро станет понятно, под какую поисковую систему следует затачивать поиск, то есть, что для вашего сайта будет более приоритетным.

Стоит сказать и о поисковике Mail.ru, доля которого в Интернете равняется приблизительно 10%, обуславливается это тем, что на всех его сервисах собирается большая аудитория, которая количественно превышает посетителей Яндекса. Стоит учитывать, что движок поиска у них иногда изменяется.

Mail.ru постоянно торгуется с Yandex и Google, чтобы ему предоставили лучшие условия. И если это не удается согласовать, он начинает пользоваться своим движком gogo.ru.

Так что, как видим, SEO оптимизатор обязан любыми, доступными и известными ему способами, заставить перечисленные выше поисковые машины заинтересоваться ресурсом, который он продвигает (как минимум, полностью индексировать сайт) и сделать так, чтобы они полюбили его. Каким образом это получится у оптимизатора – неважное, главное проявить хитрость и умение.

Это все происходит в условиях, когда в лицензиях поисковых машин четко прописано, что, когда происходит ранжирование и определение релевантности документов, интересы при поиске учитывать они будут только пользовательские, но никак не владельца сайта.

Поисковая оптимизация, или какими ее видами пользуются оптимизаторы?

Учитывая, то, что мы изложили выше, оптимизаторам приходится проявлять хитрость и даже сознательно идти на нарушение лицензионного соглашения. И от того, какие были предприняты ухищрения и насколько сильно нарушены правила использования поисковиков, SEO оптимизация может быть:

1. Белая – действия и методы, которые использует специалист, будут полностью отвечать лицензионному соглашению поисковых машин. Такой путь трудоемкий, отдача, по времени, будет видна не скоро и не очень высокая. Но, с другой стороны, это стабильный и надежный способ, в будущем заказчик не столкнется с проблемами пессимизация, фильтра, а также бана.

- Если вас интересует по каким запросам целевая аудитория, которая использует Яндекс или Гугл, сможет попасть на ваш ресурс, то это сборка смыслового ядра (семантика) при помощи, к примеру, подборки ключевых фраз или слов в Вордстате. А также создание оптимизированных страниц под эти ключевики. Поисковые машины одобряют такой подход, так как он упрощает поиск информации релевантной запросу. Конечно, мы имеем в виду не переоптимизацию, что нарушает правила лицензии.

- Также можно говорить здесь об оптимизации структуры контента, а также о перелинковки внутри него. Системы поиска и здесь не проявят никакого возражения, если это сможет помочь их роботам в ускоренном режиме найти и обработать существующий контент. А еще и показать, что материалы, которые имеются на вашем ресурсе, очень важны, но только не увлекайтесь, фанатизм в этом деле не приветствуется.

- Наращивать ссылочную массу нужно естественно. Главным словом в данном контексте является «естественное», подробнее об этом упомянем позже.

2. Серая – не все методы и нюансы будут отвечать лицензионному соглашению поисковиков, но такой способ особенно популярный среди оптимизаторов и массово распространен среди специалистов. Но, учитывайте, что манипулятивные способы, используемые для выдачи, могут быть наказаны, то есть ваш ресурс подпадет под санкции (фильтры).

- Вы можете покупать или обмениваться ссылками в крупных масштабах.

- Переоптимизация текстового контента (спам ключевиками). Это делается для того, чтобы поднять релевантность в глазах поисковых машин.

3. Черная – это уже целенаправленное и откровенное отступление от лицензии поисковых машин. За это практически гарантировано вы получите санкции. Открытым остается вопрос только когда, в течение какого времени, будет выявлено такое нарушение.

Но, несмотря на жесткое наказание, такие способы и сейчас некоторые специалисты используют. Вы и сами сможете, если внимательно понаблюдаете за выдачами Yandex и Google по некоторым запросам, скажем, засилье дорвеев. Да и в поисковом индексе можно встретить много ГС. А сейчас мы с вами, не конкретизируя особо, перечислим некоторые способы, которыми пользуются для черного SEO.

- Дорвеи, а также ГС – это намеренно созданные вручную, возможно, и автоматически, сайты, их называют «плохими», для обманывания поисковых машин (попадать в индекс, для последующей продажи ссылки, а иногда и в Топ выдачу, для трафика, который попадает на эти ресурсы, для последующей перепродажи). Такие сайты ничего хорошего посетителям предложить не могут.

- Клоакинг.

- Невидимый контент (скрытый текст).

- И некоторые другие методы, о которых вы можете почитать в лицензионных соглашениях поисковых систем, например, Яндексе.

Деятельность SEO оптимизатора или что он обязан знать о работе поисковых машин?

Но, чтобы использовать вышеперечисленные способы и методы оптимизации, специалист обязан понимать хотя бы некоторые общие принципы, по которым работают поисковики.

И, если этот человек является любителем ловли рыбки в мутной воде и планирует заниматься SEO авантюризмом (то есть, подбирать рискованные способы для оптимизации сайта), тогда он должен иметь очень глубокие и более детальные познания.

Регистрация ресурса в поисковых машинах (индексация)

Поисковики начинают свою работу с бота (поискового робота), который является обычной компьютерной машиной (сервер), имеющей соответствующее ПО. Бот обходит уникальный и качественный контент, он ищет вебстраницу. Когда он находит нужное, тогда он определяет содержимое, то есть качество и объем. Если содержимое ему понравилось, тогда данная страница переходит на следующий, поисковый, уровень.

Так как имеются и некоторые аппаратные ограничения, роботы не могут носиться по Рунету как заведенные. У них есть свои правила, которыми они и руководствуются.

Изначально, они идут на страницы, где проставлено множество ссылок из страниц, которые на данный момент уже существуют в индексной базе. Да и частота следующих посещений может и не быть высокой, и ее нужно всегда учитывать индивидуально.

В поисковой системе Yandex можно акцентировать внимание на двух типах роботов:

- Основной бот – индексирование ключевого контента, который не является новостным, тогда, когда есть смысл добавлять его в поисковую выдачу. Ранжирование по этому типу происходит в полный цикл.

- Быстроробот – поисковый бот, который обязан выдавать только самый свежий материал. Этот тип заходит на ресурсы, которые постоянно предоставляют новую информацию. Это, к примеру, блоги, имеющие RSS ленту или сайти, наполняющиеся новостями. Ранжирование страниц, найденных этим ботом, происходит за своими параметрами, основываясь только на некоторых внутренних фактора. Такой контент мгновенно можно увидеть при выдаче. Также указывается и дата создания. Но вот следующий день может коренным образом поменять ситуация, позиции запроса изменяются, как только начинает работать основной робот индексатора.

Индексный поиск необходимой информации

Поисковая система является всего лишь обычным сервером, правда имеет другое программное обеспечение. Перед ним стоят следующие задачи: обход страниц, которые находит бот, скачивание содержания этих страниц и дальнейшая обработка – создание индекса.

Те страницы, которые были отмечены роботом, выкачиваются (берутся исходные Html коды), из них достается контент, то есть текст, который был в Html коде и который будет видеть аудитория, посещающая данный сайт.

Дальше этот контент разбирается и анализируется. Контент из интернет страницы переписывается в новый файл (это делается условно), куда так же переписываются и ссылки, имеющиеся на странице, которые потом также отправляются боту, что бы он посетил и их.

Данный текст обрабатывается, из него убирают все стоп-слова (в виде союзов и предлогов), а также знаки препинания. А теперь то, что вышло, все оставшиеся слова, разбирают на пассажи, которые по принципу предложений, имеют смысловую законченность, только говорить о том, что это предложение, после машинного анализа предоставленного на русском языке контента не приходится.

Проще говоря, такой анализ производится не по физическим (которые с самого начала были в тексте) предложениям, а именно по тем, которые были созданы машиной, и называются пассажи. Вот эти пассажи и делают индексную базу, и каждому из них дается определенный вес, который и характеризирует, насколько важен текст, имеющийся внутри.

В чем же может заключаться его вес? Можно, например, говорить о релевантности пассажа, о том, сколько раз его можно встретить и где же он располагается внутри самого контекста.

И, как итог, идет формирование базы данных (поискового индекса). Здесь все вебстраницы, получившие индексацию, выдаются в виде набора пассажей с устраненными шумовыми словами (которые являются бессмысленными, связующими, паразитами и повторениями). Вот поэтому индексу или базе и происходит поиск.

Релевантность текста, как она определятся? Что такое ранжирование результатов?

Поисковый сервис (находящийся в самом верху к пользователям поисковик) принимает пользовательский запрос, и выбирает, исходя из расчета релевантности и используя фактор ранжирования, подходящие страницы в Интернете, как результат выдачи (серп), которые и увидит человек, давший задание поисковой системе.

Если говорить просто, тогда это будет выглядеть так: посещая Яндекс (или другую поисковую систему), пользователь дает задание поисковику в виде вопроса, и она начинает смотреть свою индексную базу, где и находит страницы с пассажами, которые и соответствуют данному запросу. Список релевантных страниц еще пройдут ранжирование (расставление приоритетов), говоря проще, в какой последовательности будут идти найденные вебресурсы при выдаче.

Первый используемый принцип – это индекс цитирования. Он используется уже давно и базовая версия такого принципа учитывает количество упоминаний предоставленной страницы (то есть число ссылок, через которые можно перейти на нее). Но есть и недостаток данной системы – это то, что она не учитывает качество предоставленных ссылок, а только их количество.

Вот почему и придумали взвешенный индекс цитирования, учитывающий именно авторитетность и качественность ресурсов, которые ссылаются на данный сайт. Появились веса (статистические), переходящие по ссылкам. Google дал свое название такому – Пейдж Ранк, его тулбарное значение можно найти под страничками всех вебресурсов.

Описывается взвешенный индекс, как коэффициент вероятности перехода аудитории на эту страничку с любого Интернет ресурса. Говоря иначе, имея большее количество ссылок, которые приведут на нужную страницу, тем больший вес они имеют, тем большая аудитория будет его посещать, и тем авторитетнее будет этот ресурс. Рассчитать его можно благодаря формуле в несколько итераций. Но стоит помнить, что данная формула имеет тенденцию к периодическому изменению или доработке.

Нам остается только наблюдать тулбарное значение Пейдж Ранка, обновление которого происходит за несколько месяцев один раз. Узнать его можно благодаря логарифмической шкале, когда действительная разница между весовым значением вебресурсов с ПР=1 и ПР=7 становится тысячекратной, а то и более значимой.

Нужно также понимать и то, что любое значение Пейдж Ранка именно для вашего ресурса оказывать влияние на то, чтобы он выдавался в верхних позициях при запросе, не будет.

Но также алгоритм, который был вложен в расчет ПР, будет применяться для ранжирования страниц. И выходя из этого, получается, что все равно нужно иметь понятие о данном принципе – это поможет в будущем пользоваться им для своего блага.

Хотите повысить ранжирование своей страницы, учитывайте вес транслируемой ссылки

Схема Пейдж Ранка (взвешенный индекс цитирования) включает понятие передача веса по ссылке. И хотя это не совсем верная терминология, так как вес нельзя передать, его можно только транслировать, т.е. донор не может что-то потерять, устанавливая ссылку, но также акцептор, благодаря этому, может получить некоторый статистический вес. Важно понимать, что термин "статистический" вовсе не дает веса используемым ссылкам в качестве анкора.

О том, какой передаваемый вес тем или иным ресурсом в рунете могут педставлять только поисковые алгоритмы. Известно точно одно, что данный вес разделяется поровну среди всех предоставленных страниц-акцепторов, куда ведут донорские ссылки. Если придерживаться данного принципа, то можно сделать не один вывод о том, как произвести внешнюю и внутреннюю перелинковку своего ресурса.

Если сделать общий вывод принципа передачи веса, тогда можно сказать о том, что, если вы хотите прокачать любую свою страницу, необходимо, чтобы на нее шли ссылки, и очень хорошо будет, если таковые ведут с авторитетных страничек.

Вас интересует, а как же можно узнать о весе любой интернет-странице и какой же у нее авторитет? Думаю, вы уже и сами поняли. Конечно же необходимо увидеть ее значение Пейдж Ранка.

Поисковая система Yandex также имеет свой аналоговый Пейдж Ранк. Он делает расчет для всех страниц (ВИЦ), хотя узнать таковое значение вам не получится в данный момент.

Этот поисковик также припрятал среди своих запасов и тематический индекс цитирования Тиц, рассчитывая который в первую очередь учитывается именно тематическая наполненность ссылочных ресурсов.

Устанавливается он в целом для всего ресурса. Если ссылки тематические (тема получает свою оценку именно по содержательности контекста), тогда и коэффициент будет применен повышающий, если сравнивать с ссылками околотематическими или и вовсе не имеющими темы, которые могут серьезно потерять в весе.

Так что, если вы хотите нарастить Тиц, тогда применяйте ссылки не просто ресурсов, которые имеют высокий авторитет, но чтобы и по тематике они были аналогичны или очень близки вашему сайту. Да, прямо на ранжирование он не будет влиять, хотя принципы используются одинаковые, как и при выдаче построения ресурсов.

Пока что, мы с вами вели разговор только о понятии статистического веса. Но, чтобы рассчитать трансляцию веса, какой угодно ссылки поисковые машины пользуются двумя типами весов.

Вы понимаете, что первый – это, тот который мы с вами уже разбирали, статистический, он рассчитывается не учитывая сам текст ссылки (анкор). А вот второй – это динамический или анкорный, рассчитывается он, используя несколько параметров:

- Донорская тематика (контекст, который передает ссылка);

- Тематика анкорной ссылки (то есть, ее содержание);

- Акцепторная тематика (страницы вашего рсурса).

Чтобы анкорный вес транслирочной ссылки был максимально высоким, необходимо, чтобы все три пункта, перечисленные выше, имели высокую релевантность. Безанкорная ссылка, хотя и передает динамический вес, но он не рассчитывается.

А вот статистический вес будет передаваться всегда, исключение составляет только одно: донорский сайт не ищется по фильтрам поисковиков, так как продавал бэклинки.

Напрашивается немаловажный вывод: ссылка, которая передается на ваш ресурс, имеет ценность по двум весам. Первое, вы набираете статистический вес для свего ресурса – это прекрасно. Но вот. Если вы еще и искусно, и умело сможете воспользоваться анкотом, тогда значимость данной ссылки увеличивается в разы.

Теперь вы можете спросить, что же повышает вес анкора? Давайте теперь все рассмотрим по пунктам:

- Если у используемого донора есть максимально высокий авторитет в поисковике. Правильнее будет сказать, это та страничка, с которой вы проставляете бэклинк. Небольшая наводка: вам нужно посмотреть, какое имеет значение данная страница Пейдж Ранка. Чем ближе оно будет к десяти, тем лучше для вас.

- Донорская страница обязана быть очень близкой по тематике к продвигаемой вами странице-акцептору.

- Ссылочный анкор, желательно, также должен быть максимально близкий по тематике (имеется ввиду контекст).

Результаты продвижения

- OOO "ПВС"

Сайт: http://kungivsamare.ru/Сфера: Аксессуары для пикаповРегион: РоссияПродвижение:Трафик: ~7600 ч/месГрафик роста посещаемости (человек в день) по месяцам

Сайт: http://kungivsamare.ru/Сфера: Аксессуары для пикаповРегион: РоссияПродвижение:Трафик: ~7600 ч/месГрафик роста посещаемости (человек в день) по месяцам - Интернет-магазин «Аляска»

График роста посещаемости (человек в день) по месяцам

График роста посещаемости (человек в день) по месяцам - Компания «Омега-Сити»

Сайт: http://www.ssk-alpro.ru/Сфера: Производство и продажа торгового оборудованияРегион: МоскваПродвижение:Трафик: ~6300 ч/месГрафик роста посещаемости (человек в день) по месяцам

Сайт: http://www.ssk-alpro.ru/Сфера: Производство и продажа торгового оборудованияРегион: МоскваПродвижение:Трафик: ~6300 ч/месГрафик роста посещаемости (человек в день) по месяцам - Производственная компания «Технодрайв»

Сайт: http://tehno-drive.ru/Сфера: Производство и продажа приводной техникиРегион: ВоронежПродвижение:Трафик: ~2900 ч/месГрафик роста посещаемости (человек в день) по месяцам

Сайт: http://tehno-drive.ru/Сфера: Производство и продажа приводной техникиРегион: ВоронежПродвижение:Трафик: ~2900 ч/месГрафик роста посещаемости (человек в день) по месяцам - Фабрика-производитель "ЭкоМассив"

Сайт: http://eco-massive.ru/Сфера: Производство и продажа мебелиРегион: МоскваПродвижение:Трафик: ~1600 ч/месГрафик роста посещаемости (человек в день) по месяцам

Сайт: http://eco-massive.ru/Сфера: Производство и продажа мебелиРегион: МоскваПродвижение:Трафик: ~1600 ч/месГрафик роста посещаемости (человек в день) по месяцам - Туристическая компания "Тревел Бокс"

График роста посещаемости (человек в день) по месяцам

График роста посещаемости (человек в день) по месяцам - ЗАО "Литейно-механический завод "СТЭЛЛ"

Сайт: http://lmz-stell.ruСфера: Производсто деталей машин и оборудованияРегион: РоссияПродвижение:Трафик: ~11000 ч/месГрафик роста посещаемости (человек в день) по месяцам

Сайт: http://lmz-stell.ruСфера: Производсто деталей машин и оборудованияРегион: РоссияПродвижение:Трафик: ~11000 ч/месГрафик роста посещаемости (человек в день) по месяцам - Компания "Bluestone and Millmark Moscow"

График роста посещаемости (человек в день) по месяцам

График роста посещаемости (человек в день) по месяцам